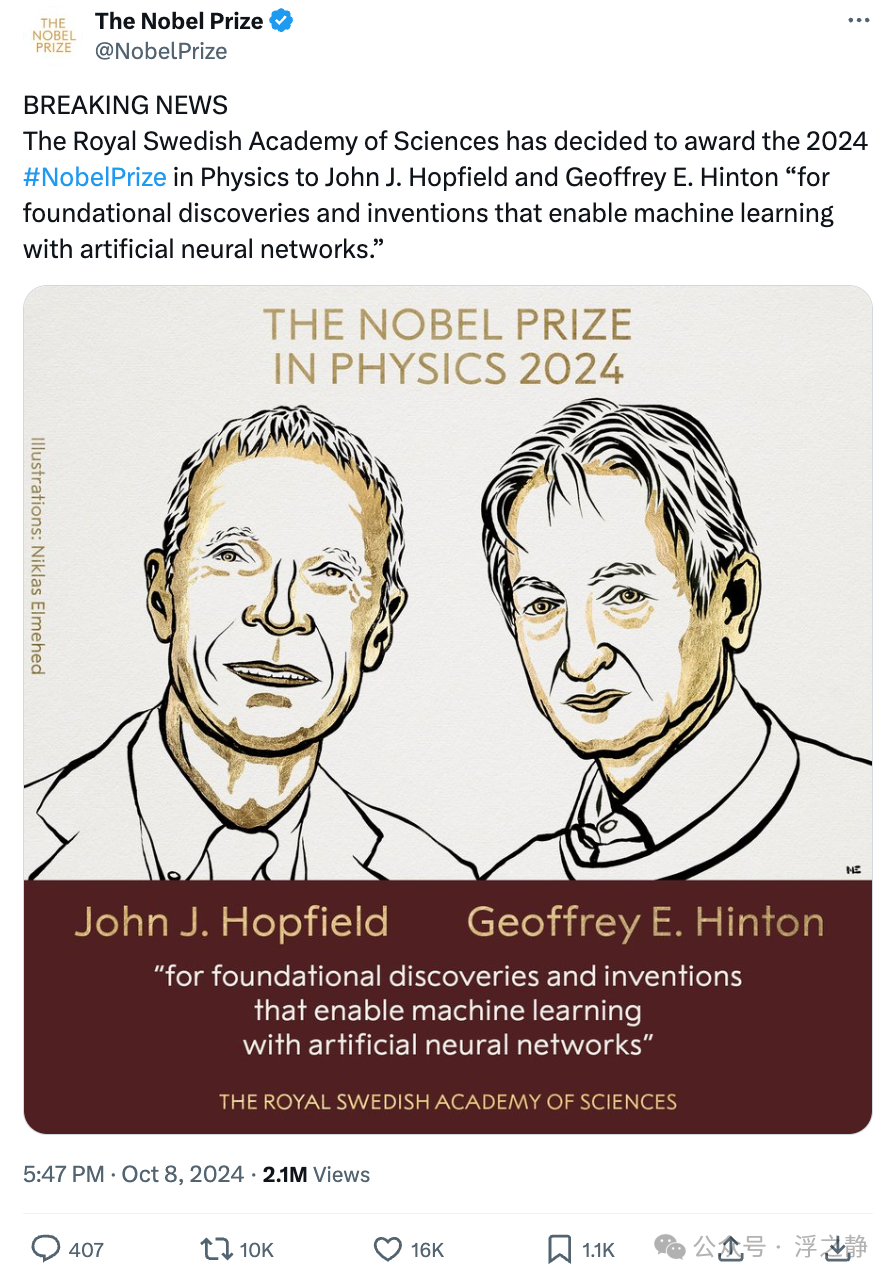

昨天有条突发新闻(The Nobel Prize in Physics 2024[1]):瑞典皇家科学院决定将 2024 年诺贝尔物理学奖授予约翰·霍普菲尔德(John J. Hopfield)和杰弗里·辛顿(Geoffrey E. Hinton),以表彰他们在机器学习及人工神经网络领域的基础性发现和发明(他们的研究利用了物理学的工具和概念,为当今强大的机器学习和人工智能技术奠定了基础)。

简介

John J. Hopfield

约翰·霍普菲尔德是一位美国科学家,1933 年出生于芝加哥,父亲也是物理学家。他于 1954 年获得斯沃斯莫尔学院文学士学位,1958 年在康奈尔大学获得凝聚态物理博士学位。在贝尔实验室、加州大学伯克利分校物理系、普林斯顿大学物理系和加州理工学院化学与生物系等机构担任研究员。霍普菲尔德因 1982 年发明了联想神经网络(现称霍普菲尔德网络)而闻名,他还参与创办了加州理工学院的计算和神经系统博士项目。

Geoffrey E. Hinton

杰弗里·辛顿是英裔加拿大计算机科学家,以其在人工神经网络和深度学习领域的贡献而闻名,被称为“人工智能教父”。他曾与 David Rumelhart 等人共同推广了反向传播算法(BP:Backpropagation),并与学生 Alex Krizhevsky 和 Ilya Sutskever 合作设计了在计算机视觉领域取得突破的 AlexNet(是一种卷积神经网络架构的名称)。辛顿与 Yoshua Bengio 和 Yann LeCun 共同获得了 2018 年图灵奖(计算机领域的诺贝尔奖)。2023 年,辛顿辞去谷歌大脑(Google Brain)职务,公开表达对人工智能技术风险的担忧,呼吁制定安全准则以应对潜在的威胁。

主要成就

他们究竟做了什么可以获此殊荣,他们的工作又为何如此重要?接下来让我们细聊,这可能也是最具争议的一次诺奖(很多人表示不理解,为啥搞 AI 的领了个物理学奖项,难道物理学没人了嘛)。

人脑启发

如今,人工智能已经成为我们日常生活的一部分。我们的手机可以识别面部和指纹,智能音箱可以听懂我们的指令,网络平台可以根据我们的喜好推荐内容。但这些令人惊叹的功能背后,依赖的是一种被称为机器学习的技术,特别是其中的人工神经网络。

传统的软件编程就像是一份详细的食谱,告诉计算机每一步该做什么。然而,现实世界的问题往往过于复杂,无法用固定的规则来解决。比如,如何让计算机识别一张图片中的猫?猫有不同的品种、颜色、姿态,很难用一套固定的规则来描述。

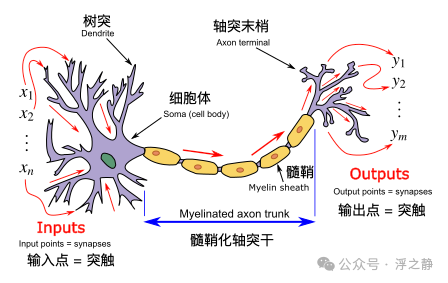

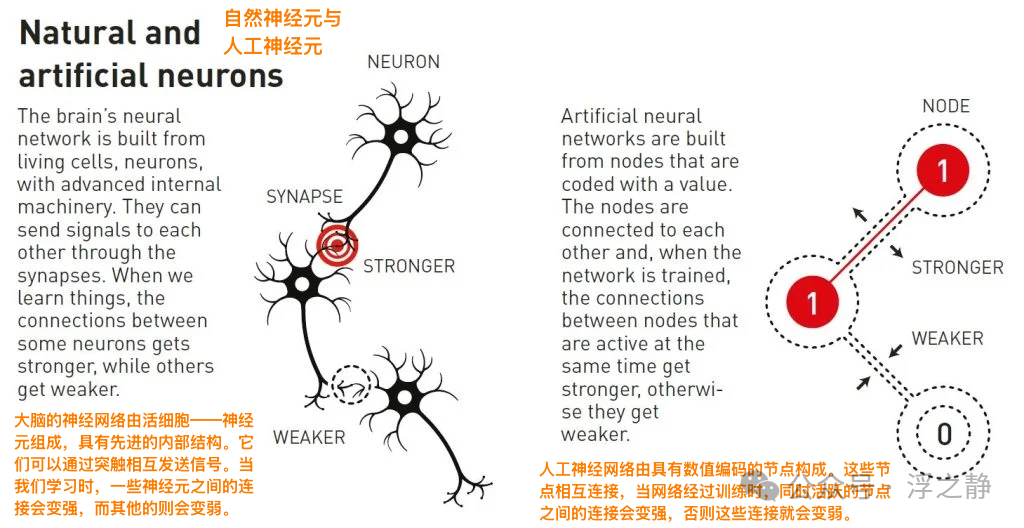

机器学习的出现改变了这一局面。它让计算机通过大量的示例数据,自主学习如何完成任务,就像人类通过经验来学习一样。而人工神经网络则是受人脑启发的一种计算模型,它模拟了大脑中神经元之间的连接和信号传递。

模拟大脑

早在 20 世纪 40 年代,科学家们就开始尝试用数学和计算机来模拟大脑的工作原理。他们希望理解,数以亿计的神经元如何通过复杂的网络结构,让我们能够思考、学习和记忆。

约翰·霍普菲尔德与关联记忆

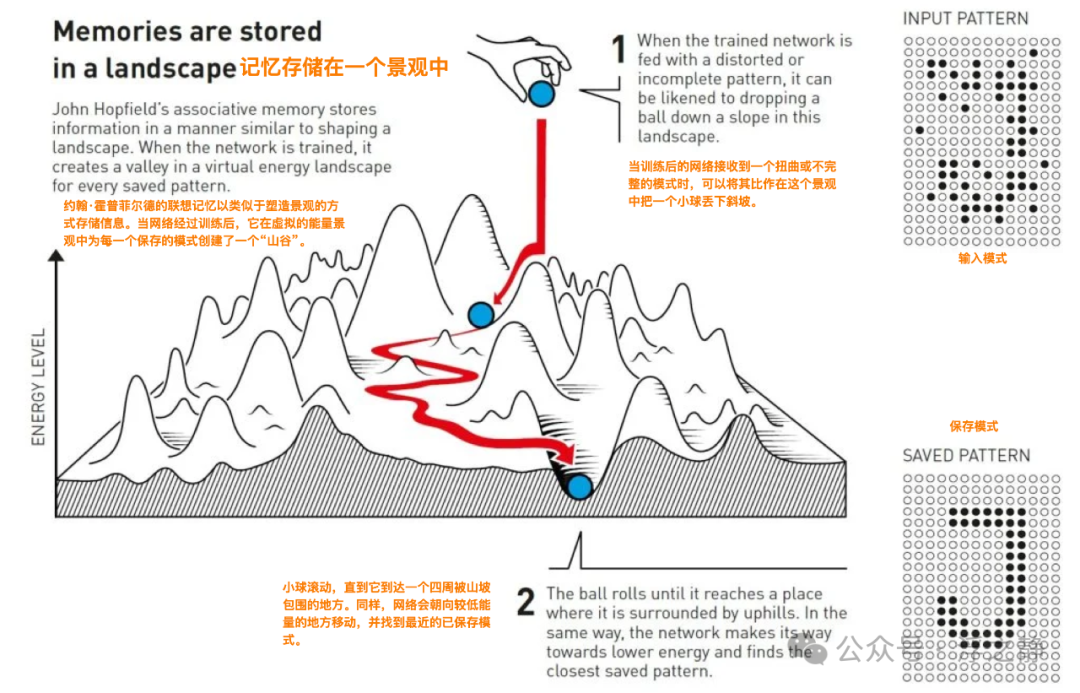

约翰·霍普菲尔德在 1982 年提出了一种能够存储和重现信息的网络结构(Neural networks and physical systems with emergent collective computational abilities.[2]),被称为霍普菲尔德网络(Hopfield network[3])。这个网络可以理解为一种关联记忆模型。它能够从部分或受损的输入中,重建出最接近的已知模式。

举个例子,想象你在回忆一个很少用的英文单词,比如“梯形教室”的“梯度”。你可能只记得它的开头或部分拼写,通过联想和关联,最终找到正确的词。霍普菲尔德网络就像这种过程,当给它一个不完整的输入时,它可以根据已存储的记忆,找到最匹配的结果。

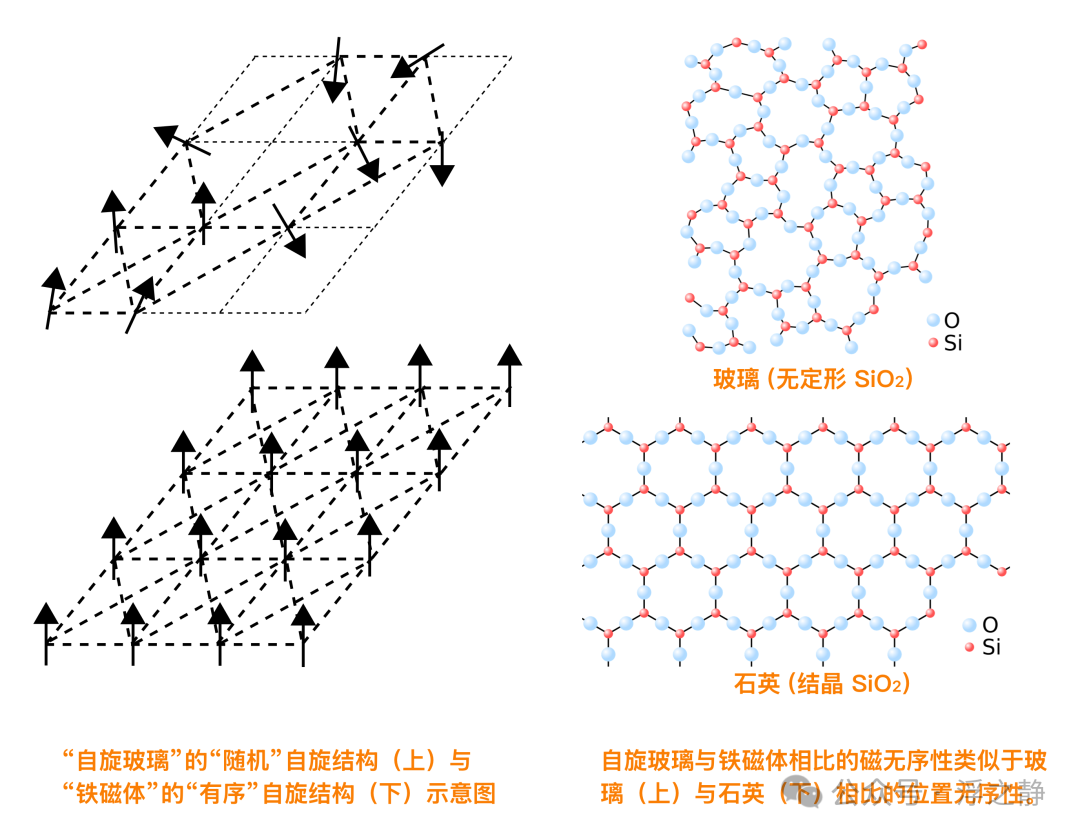

但霍普菲尔德如何用物理学来实现这一点呢?他借鉴了统计物理学中的概念,特别是自旋玻璃(Spin glass[4])模型。在物理学中,自旋玻璃是研究具有随机相互作用的磁性系统。其中,原子的自旋可以向上或向下,邻近原子的自旋相互影响,形成复杂的能量景观。

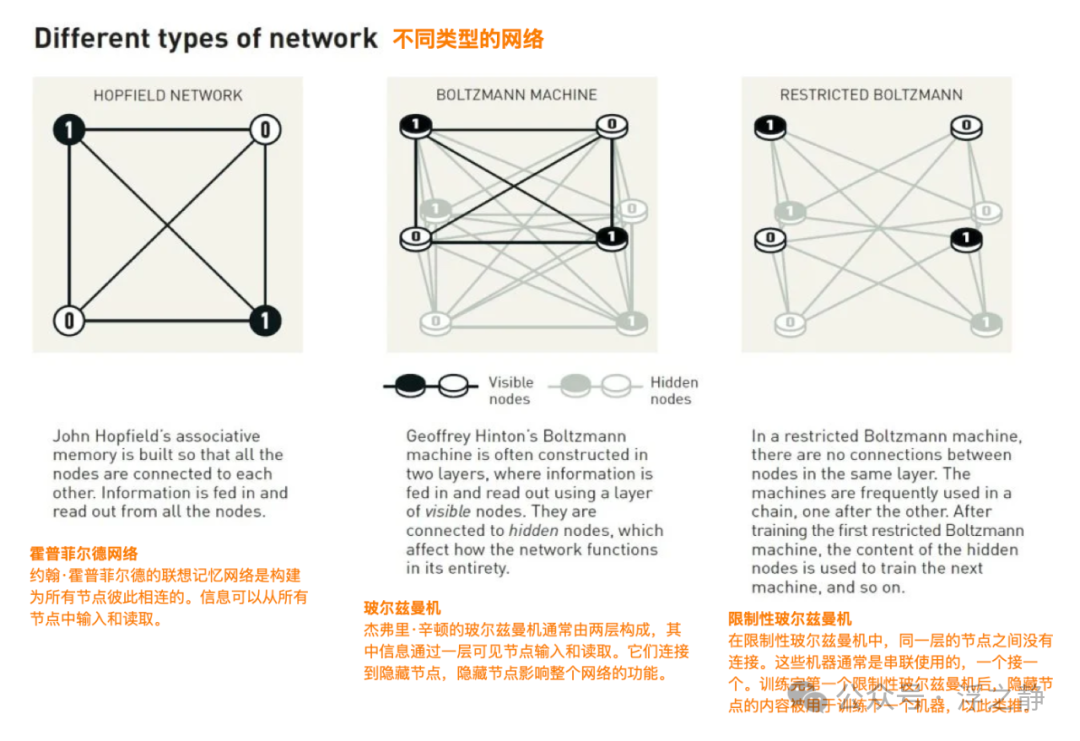

霍普菲尔德将这种概念应用于神经网络。他将网络中的每个节点视为一个“自旋”,可以取 0 或 1(类似于向下或向上)。节点之间的连接强度对应于原子之间的相互作用。他定义了一个“能量函数”,描述整个网络的状态。当网络接收到一个输入后,通过不断调整节点的状态,使得网络的总能量降低,最终达到一个稳定状态。这个过程就像在一个山谷和山峰组成的能量景观中滚动小球,小球最终会停在最低的能量点。这对应于网络找到最匹配的记忆。

📌 霍普菲尔德网络

Hopfield 网络(或联想记忆)是一种循环神经网络,或自旋玻璃系统,可以用作内容可寻址的记忆。该网络以约翰·霍普菲尔德(John Hopfield)命名,由一层神经元组成,其中每个神经元都与除自身外的其他神经元相连接。这些连接是双向且对称的,即神经元 i 到神经元 j 的连接权重与神经元 j 到神经元 i 的权重相同。通过固定某些输入,可以联想性地回忆模式,网络通过动态演化来最小化能量函数,趋向局部能量最小状态,这些状态对应于存储的模式。模式通过赫布理论(Hebbian theory[5])学习算法联想性地学习(或“存储”)。

Hopfield 网络的一个关键特征是它能够从部分或有噪声的输入中恢复完整的模式,使其在面对不完整或受损数据时表现出鲁棒性(robust)。由于其与统计力学、循环网络以及人类认知心理学的联系,Hopfield 网络在物理学、心理学、神经科学和机器学习理论与实践等多个领域得到了应用。

📌 赫布理论

赫布理论(Hebbian theory)是由唐纳德·赫布于 1949 年提出的一个神经科学理论,阐述了学习过程中神经元之间的变化。该理论解释了突触可塑性的原理,即当突触前神经元对突触后神经元进行持续、重复的刺激时,突触传递效能会增强。这种现象被总结为“同时激发的神经元连在一起”(Cells that fire together, wire together),但赫布强调神经元 A 必须在神经元 B 激发之前对其做出贡献,因此存在时间延迟。这一延迟被称为脉冲时序依赖可塑性,表明突触可塑性需要时间差异。赫布理论为联合学习提供了基础,解释了神经元之间通过重复刺激增强突触强度的现象,且成为了非监督学习的重要生物学依据。这种学习机制被称为赫布型学习(Hebbian learning)。

📌 自旋玻璃

自旋玻璃(Spin glass)是磁性合金材料的一种亚稳定的状态。铁磁性状态和反铁磁性状态中,磁矩的磁矩方向(自旋)的分布是长程有序的,而自旋玻璃状态中的磁矩方向是随机冻结的,其分布呈现出长程无序性。这里的“玻璃”实际上是长程无序状态的代名词,指这种无序状态类似于一般所说的玻璃。自旋玻璃表现出的众多亚稳定结构,使得它具有明显的磁化弛豫现象,这也使得实验和模拟自旋玻璃的难度加大。

应用与扩展

霍普菲尔德网络的一个重要特性是内容可寻址性。这意味着你不需要知道存储信息的具体地址,只需要提供部分内容,就能检索出完整的信息。这在纠错、模式识别等领域有重要的应用。

后来,研究人员进一步扩展了霍普菲尔德网络的能力。例如,让节点可以取连续值,而不仅仅是 0 或 1;或者增加网络的规模和复杂度,以存储和处理更复杂的信息。

从记忆到理解:杰弗里·辛顿与玻尔兹曼机

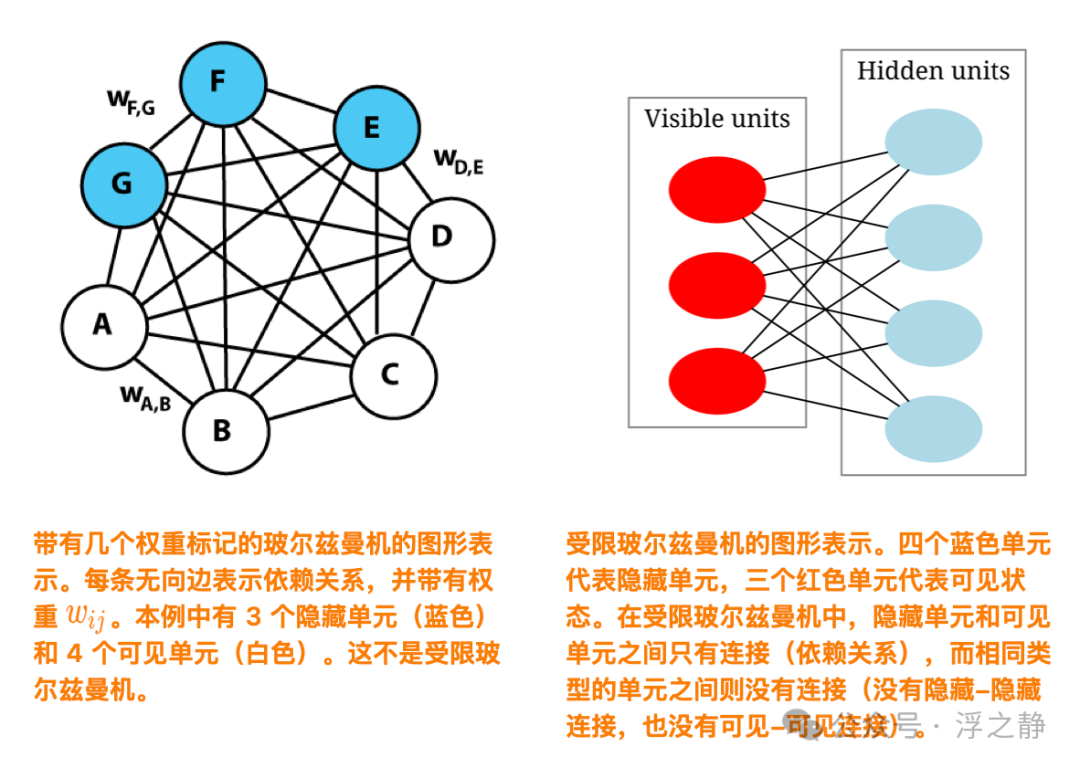

记住信息是一回事,理解和分类信息又是另一回事。杰弗里·辛顿在这方面做出了开创性的贡献。他与同事们在 1985 年提出了玻尔兹曼机(Boltzmann machine),一种能够学习和分类数据的随机神经网络。

统计物理学与玻尔兹曼机

玻尔兹曼机的灵感来自统计力学中的玻尔兹曼分布(Boltzmann distribution)。在物理学中,玻尔兹曼分布描述了粒子在不同能量状态下的概率分布,能量较低的状态具有较高的概率。

辛顿将这一概念应用于神经网络。他设计的玻尔兹曼机由两层节点组成:可见层和隐藏层。网络中的节点状态可以随机变化,但变化的概率由网络的能量函数和玻尔兹曼分布决定。

通过反复调整网络的连接权重,玻尔兹曼机能够从输入数据中学习模式和特征。它可以在没有明确标签的情况下,发现数据中的隐藏结构。这种能力被称为无监督学习。

举例说明

想象你有一大堆动物的图片,但没有告诉计算机哪些是猫,哪些是狗。玻尔兹曼机可以通过学习,发现这些图片可以分为不同的类别。即使给它一张新的、从未见过的猫的图片,它也能根据学到的特征,将其归入正确的类别。这就像你遇到朋友的兄弟姐妹,虽然你以前没见过他们,但可以根据相似的特征判断出他们的亲缘关系。

深度学习的开端

虽然早期的玻尔兹曼机在计算效率上存在问题,但辛顿和他的同事们不断改进模型。2006 年,他们提出了深度置信网络,这是深度学习的开端。通过逐层预训练的方法,他们解决了深层神经网络训练困难的问题。

这种方法使得神经网络能够学习更抽象、更高级的特征,大大提升了模型的性能。这也是为什么我们今天能够训练出庞大的深度神经网络,应用于图像识别、语音识别、自然语言处理等领域。

📌 深度学习

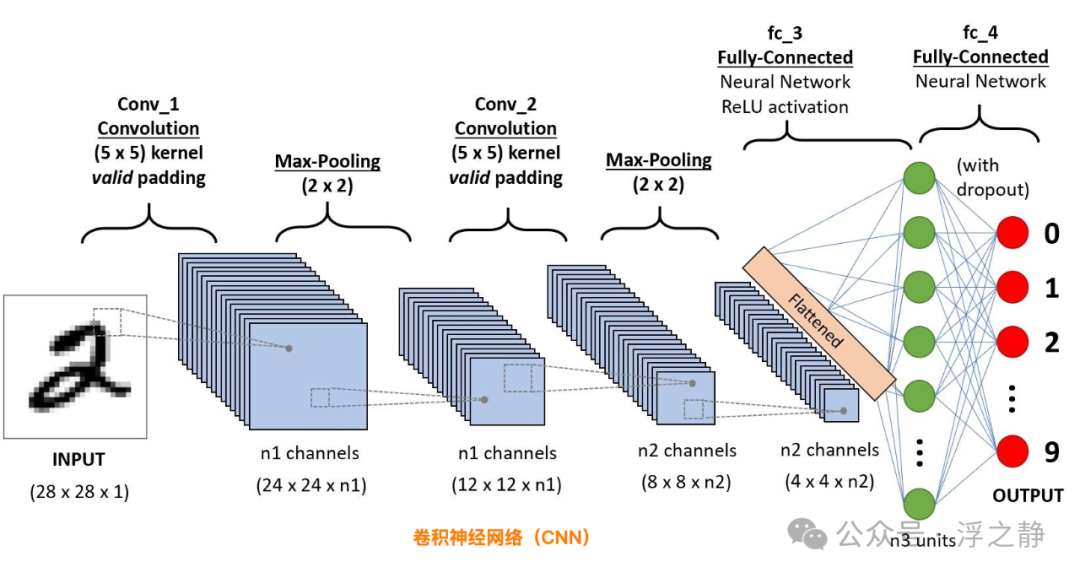

深度学习(Deep learning[6])是机器学习的分支,一种以人工神经网络为架构,对资料进行表征学习的算法。该领域从生物神经科学中汲取灵感,核心在于将人工神经元堆叠成层,并通过“训练”它们来处理数据。“深度”一词指的是网络中使用了多个层(从三层到几百层甚至几千层)。深度学习的方法可以是监督式、半监督式或无监督式的。

一些常见的深度学习网络架构包括全连接网络(Fully connected network)、深度置信网络(DBN:Deep belief network)、循环神经网络(RNNs:Recurrent neural network)、卷积神经网络(CNN:Convolutional neural network)、生成对抗网络(GAN:Generative adversarial network)、变换器(Transformer)和神经辐射场(NeRF:Neural radiance field)。这些架构已广泛应用于计算机视觉、语音识别、自然语言处理、机器翻译、生物信息学、药物设计、医学图像分析、气候科学、材料检测和棋类游戏程序等领域,在这些领域中,深度学习的表现与人类专家相当,甚至在某些情况下超越了人类专家。

早期的神经网络形式受到生物系统中的信息处理和分布式通信节点的启发,尤其是人脑。然而,当前的神经网络并不试图模拟生物体的大脑功能,通常被认为是对此用途的低质量模型。

现在与未来

得益于霍普菲尔德和辛顿的开创性工作,机器学习和人工智能在过去的十几年中取得了突破性的发展。如今的人工神经网络规模巨大,拥有数以亿计、甚至数以万亿计的参数。以霍普菲尔德最初的网络为例,他在 1982 年的论文中使用了仅 30 个节点,总共约 500 个参数。而现在的大型语言模型,如 GPT-4,参数量已经达到数万亿级别。这种飞跃得益于计算能力的提升和海量数据的积累。高速的 GPU 和专用芯片让我们能够训练复杂的模型,而互联网和数字化进程为模型提供了丰富的训练数据。

机器学习已经渗透到各行各业。在医学领域,深度学习被用于疾病诊断、药物研发和基因分析。在物理学和天文学中,机器学习帮助科学家处理庞大的数据集,如大型粒子对撞机产生的数据,或者引力波探测器的信号。例如,机器学习被用于从噪声中提取引力波信号,帮助发现来自黑洞合并的引力波事件;在材料科学中,机器学习被用于预测新材料的特性,加速材料的设计和应用。

然而,随着人工智能的快速发展,我们也面临着新的挑战和伦理问题:

-

透明性和可解释性:深度学习模型往往被视为“黑箱”,难以理解其内部工作原理。这在某些关键领域,如医疗和法律,会引发信任和责任问题。

-

数据隐私和安全:模型需要大量的数据进行训练,这涉及个人隐私和数据安全的问题。

-

道德和法律:人工智能的发展引发了对就业、社会公平和法律责任的思考。如何确保技术的使用符合道德规范,是我们需要认真对待的问题。

结语

今年的诺贝尔物理学奖不仅肯定了约翰·霍普菲尔德和杰弗里·辛顿的卓越贡献,同时也提醒我们跨学科研究的重要性。他们利用物理学的思想和工具,推动了计算机科学和人工智能的发展。在未来,随着技术的不断进步,人工智能将继续对我们的生活和社会产生深刻影响。

延伸阅读

恶作剧

“我怎么能确定这不是一个恶作剧电话呢”?2024 年诺贝尔物理学奖得主 Geoffrey Hinton 接到了来自斯德哥尔摩的电话,当时他在加州的酒店房间里,电话是在清晨打来的,多种瑞典口音让他确信这个诺贝尔物理学奖是真的。在这个刚刚得知获奖消息后的采访中,他谈到了机器学习的现状、对安全研究的迫切需求,以及他希望这项奖项能够让人们更加认真对待他所表达的担忧(查看录音 Geoffrey Hinton Interview[7])。

采访实录

Geoffrey Hinton:你好?

Adam Smith:哦,你好。我在和 Geoffrey Hinton 通话吗?

GH:是的。

AS:我是来自诺贝尔奖官网的 Adam Smith。

GH:好的,我知道你是谁,因为很久以前我注意到他们会派人打电话来获取获奖者的反应。

AS:正是如此。那我们能聊几分钟吗?

GH:可以。

AS:非常感谢。首先,当然要祝贺你获奖。

GH:谢谢。

AS:你在哪里?消息是在哪里传达给你的?

GH:我在加州一家廉价酒店,没有网络连接,而且电话信号也不太好。我本来今天要做核磁共振扫描(MRI),但我想我得取消了。我根本不知道自己被提名了诺贝尔物理学奖,所以非常惊讶。

AS:听起来这个地方在某种程度上还算合适,因为你有些与世隔绝,可以在面对接下来的一天之前整理一下思绪。

GH:是的。另一方面,现在是凌晨两点。

AS:哦,天哪,对不起。我不知道……

GH:我想现在已经是凌晨三点了。

AS:……我不知道你能不能淡定地再去睡觉,还是只能接受今天会是漫长的一天。

GH:是的,我想我没法淡定地再去睡觉了。

AS:真是个巨大的惊喜。你最初的想法是什么?

GH:我最初的想法是,怎么能确定这不是恶作剧电话。

AS:那你是怎么确认的?

GH:电话来自瑞典,接线员有很重的瑞典口音,而且不止一个人。

AS:是啊,得有一群模仿者才行,但这不太可能。

GH:是的。

AS:你如何描述自己?你认为自己是计算机科学家,还是物理学家,或者是在试图理解生物学的物理学家?

GH:我会说我是一个不太确定自己属于哪个领域,但想了解大脑如何运作的人。在试图理解大脑如何工作的过程中,我帮助创造了一种出乎意料地有效的技术。

AS:我想特别值得注意的是,你曾公开表达了对这项技术带来潜在危险的担忧。你认为要缓解你和其他人表达的这些担忧,需要做些什么?

GH:我认为这和气候变化很不同。对于气候变化,大家都知道需要做什么,我们需要停止燃烧碳,这只是一个政治意愿的问题,还有大公司为了巨额利润不愿意这样做。但我们明确知道该怎么做。面对 AI,我们对将会发生的事情以及如何应对的认识要少得多。因此,我希望我有一个简单的解决方案,告诉大家如果你做这个,一切都会好起来。但我没有。尤其是在关于这些技术失控并接管世界的存在性威胁问题上,我认为我们正处于历史的分叉点,接下来的几年里,我们需要找到一种方法来应对这种威胁。因此,我认为现在非常重要的是,人们要努力研究如何保持控制。我们需要投入大量的研究力量。我认为政府可以做的一件事是迫使大公司将更多的资源用于安全研究。例如,像 OpenAI 这样的公司不能只是将安全研究放在次要位置。

AS:这是否与生物技术革命类似?当时生物技术领域的科学家们在 Asilomar 会议上聚集,讨论这些技术的潜在危险,并认为需要主动应对。

GH:是的,我认为这有相似之处,而且他们当时的做法非常好。不幸的是,AI 有更多的实际应用,而当时生物学家试图控制的东西,比如克隆技术,应用相对较少。所以,我认为控制AI会更加困难。但我认为生物学家们的做法是一个很好的榜样。他们达成了共识,这一点令人印象深刻,而且是科学家们自己做到的。

AS:比如对于大型语言模型,可能加剧你担忧的一点是你认为这些模型比很多人所说的更接近理解。你认为诺贝尔奖对这个领域的影响会是什么?

GH:是的,我认为它会产生影响。希望这能让我在表达这些技术确实理解其内容时更具可信性。

AS:你担心人们不把你当回事吗?

GH:有一整个来自乔姆斯基的语言学学派认为,说这些技术理解语言是完全无稽之谈,认为它们处理语言的方式与我们完全不同。我认为这个学派是错的。我认为现在很清楚,神经网络在处理语言方面比乔姆斯基学派的任何理论都要好。但在语言学界,这仍然有很多争论。

AS:我想回到你接到这个消息的情景,在你酒店房间的深夜中。这在某种程度上是一个相对孤独的时刻,没有人可以拥抱庆祝。

GH:嗯,我和我的伴侣在这里。她很兴奋。

AS:哦,那就好。再次祝贺你。

GH:谢谢。再见。

AS:再见。

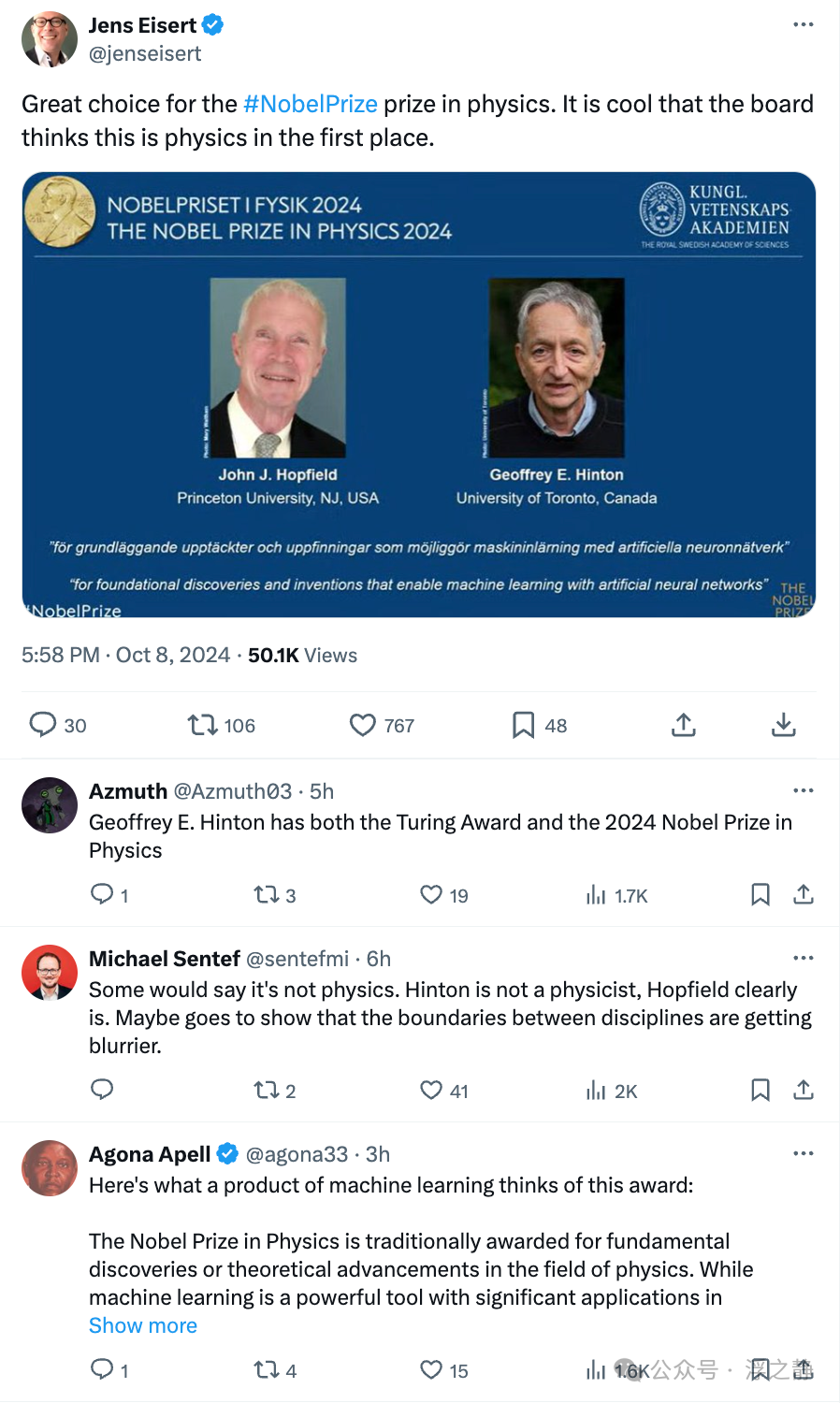

祝贺帖

帖一

Jens Eisert(量子物理学教授):对于物理学诺贝尔奖的选择非常棒。很酷的是,诺贝尔委员会一开始就认为这是物理学。

Michael Sentef(量子物理学家):有些人可能会说这不是物理学。辛顿不是物理学家,而霍普菲尔德显然是。也许这表明学科之间的界限变得越来越模糊。

Agona Apell:这是一个机器学习产物对这个奖项的看法:

-

诺贝尔物理学奖通常授予在物理学领域的基础性发现或理论进展。虽然机器学习是一个强大的工具,并且在物理学中有着重要的应用,但仅仅因为机器学习方面的成就而获得诺贝尔物理学奖可能是非典型的。

-

如果某个人或团队开发了突破性的机器学习技术,并因此大大推动了对物理系统的理解,或者对理论物理学做出了重大贡献,或者促进了新物理现象的发现,那么这种成就有可能被考虑授予诺贝尔奖。例如,如果机器学习在粒子物理学、宇宙学或凝聚态物理学的变革性发现中发挥了关键作用,那么这可能会成为获奖的条件。

-

诺贝尔奖的评选标准不仅强调创新,还强调工作对整个物理学领域的影响。因此,虽然机器学习本身可能不是焦点,但其应用于物理学中的突破性发现,完全有可能获得最高级别的认可。

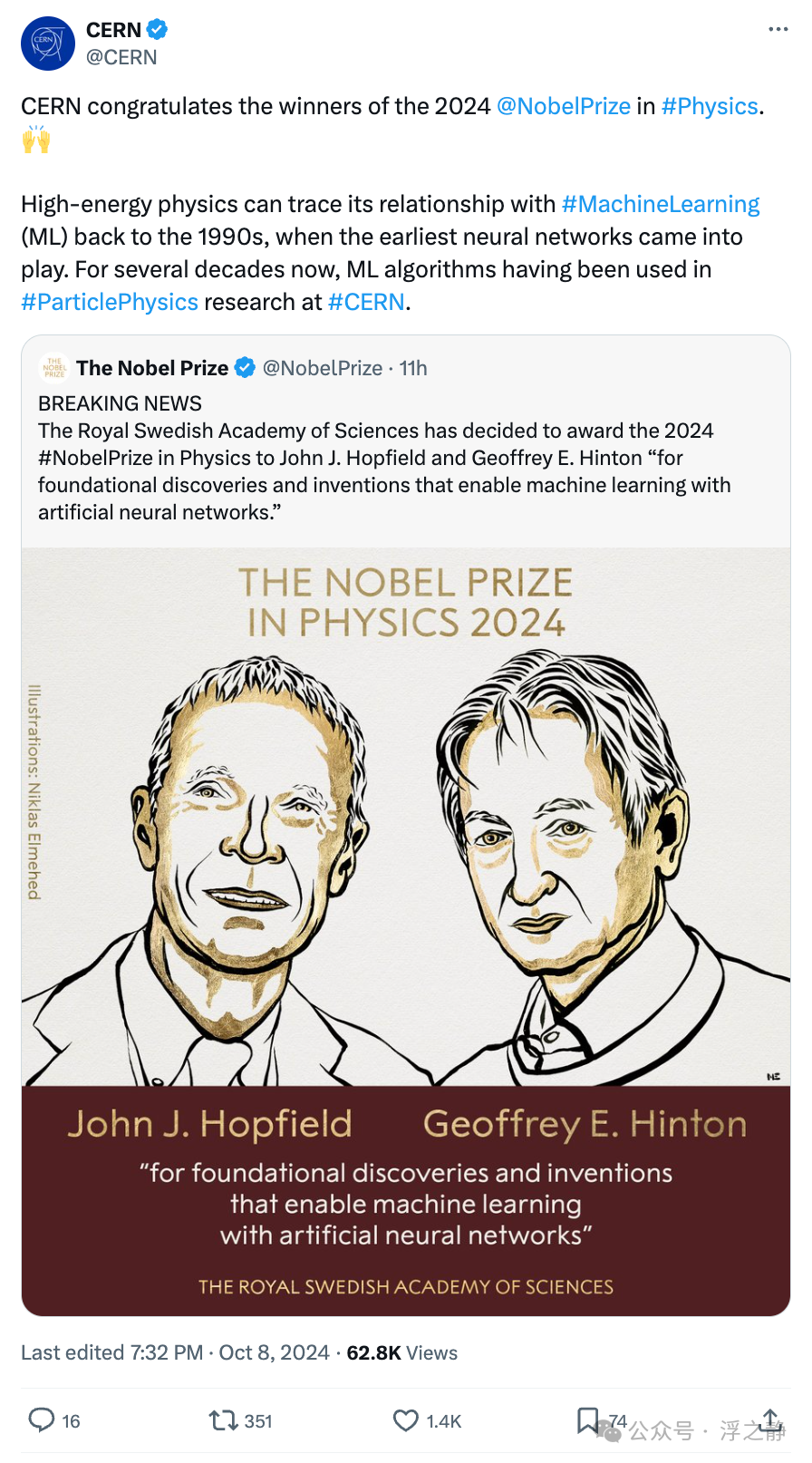

帖二

欧洲核子研究中心(CERN)祝贺 2024 年诺贝尔物理学奖得主。高能物理与机器学习(ML)的关系可以追溯到 1990 年代,当时最早的神经网络开始发挥作用。几十年来,ML 算法一直被应用于 CERN 的粒子物理研究中。

帖三

Ilya Sutskever 师从 Geoffrey Hinton,在离开 OpenAI 后,创立了一家致力于开发安全超级智能的公司(SSI:Safe Superintelligence Inc.)。其唯一目标是解决我们时代最重要的技术挑战:构建安全的超级智能(与导师对 AI 的担忧一致)。

References

The Nobel Prize in Physics 2024: https://www.nobelprize.org/prizes/physics/2024/popular-information

[2]

Neural networks and physical systems with emergent collective computational abilities.: https://www.ncbi.nlm.nih.gov/pmc/articles/PMC346238

[3]

Hopfield network: https://en.wikipedia.org/wiki/Hopfield_network

[4]

Spin glass: https://en.wikipedia.org/wiki/Spin_glass

[5]

Hebbian theory: https://en.wikipedia.org/wiki/Hebbian_theory

[6]

Deep learning: https://en.wikipedia.org/wiki/Deep_learning

[7]

Geoffrey Hinton Interview: https://www.nobelprize.org/prizes/physics/2024/hinton/interview

0 条评论