原因我想大家都知道,西安一码通又崩了!

1

又崩了

对,西安一码通又一次,崩了!

有人讽刺说,西安掌握了流量密码,天天可以上热搜,我刚去看了一下,西安一码通已经上微博热搜了。

然后微博上一片XX声,突然就看到了这句:我们(西安)每天都生活在,全国人民的笑话中。

说实话曾经网上看到别人黑西安,立刻有一种想要反驳的冲动,但这一次我自己都破防了。

甚至有一瞬间,我觉得他们说的都对。

西安和一线城市的差距,真的是全方位的(如果大家看了最近的新闻),一码通崩溃,只是拉开遮羞布的一角罢了。

12月20号,算得上西安崩溃的一天。

那么今天1月4号,就是上西安市民的又又一次崩溃。

1月4号是上面定的清零日期,也就说今天在社区内要做到无任何感染,要有病例也是在隔离区。

为此西安做了很多巨大的工作,包括免费送菜、整栋整栋的拉出去隔离。

这个又一次关键时刻,在中央的领导下,西安正在打攻坚战的时候,西安一码通又又一次崩溃了。。。

第一次出现问题,修复了整整一天,那么这次呢?同样的问题过去了十几天仍然再次出现了!!!

今天小区8点,西安市通知开始又一轮全市核酸检测,于是各个小区开始让大家排队做核酸。

结果很多小区都没开始做的时候,大家突然发现一码通打不开了,大家可要知道西安市现在的温度是1度,大家排队在外面的感受。

最讽刺的是,大家都还在排队的过程中,收到了市里面发过来的短信,而一码通仍然处于崩溃中。

刚开始还让等待,结果等了30分钟之后,发现仍然没有一点恢复的迹象,于是通知大家回家等待。

因为防护服穿上就不能脱,到现在还有很多医护人员和一线的志愿者,穿着防护服在寒风中等着系统恢复。

西安现在防疫压力有多大,我这里不需要再复述了,严重程度仅次于当年的武汉。

关键是这个问题有那么难吗?

关键时刻、关系到国计民生的事情,如果负责的技术团队解决不了,能不能请求一下 BAT 的专家过来帮忙支援。

到现在这个程度,已经不是钱的问题了,严重影响整个西安防控的进展了。

吐槽归吐槽,估计一码通的程序员,现在压力巨大,希望他们可以沉下心来尽快将问题解决吧。

这个级别的问题和干活的程序员关系不大,主要的责任人都在负责的相关领导身上。

希望相关领导负起责任来,将类似的问题一次性解决好,西安真的已经经不起再次再次的折腾了。。。

下面这篇文章是我在12月20号,一码通崩溃的时候写的,只能从局外人给出一些浅薄的见解。

我真的没想到,这么快曾经写的这篇文章,就可以再发第二遍,希望不要发第三遍。。。

2

产品分析

西安一码通其它业务我们暂且不分析,那并不是重点,并且当天也没有完全崩溃,崩溃的仅有扫码功能。

其实这是一个非常典型的大量查询、少数更新的业务,闭着眼睛分析一下,可以说, 90% 以上的流量都是查询。

我们先来看看第一版的产品形态,扫码之后展示个人部分姓名和身份证信息,同时下面展示绿、黄、红码。

这是西安一码通最开始的样子,业务流程仅仅只需要一个请求,甚至一个查询的 SQL 就可以搞定。

到了后来,这个界面做了2次比较大的改版。

第一次改版新增了疫苗接种信息,加了一个边框;第二次改版新增了核酸检测信息,在最下方展示核酸检测时间、结果。

整个页面增加了2个查询业务,如果系统背后使用的是关系数据库,可能会多增加至少2个查询SQL。

基本上就是这样的一个需求,据统计西安有1300万人口,按照最大10%的市民同时扫码(我怀疑不会有这么多),也就是百万的并发量。

这样一个并发量的业务,在互联网公司很常见,甚至比这个复杂的场景也多了去了。

那怎么就崩了呢?

3

技术分析

在当天晚上的官方回复中,我们看到有这样一句话:

12月20日早7:40分左右,西安“一码通”用户访问量激增,每秒访问量达到以往峰值的10倍以上,造成网络拥塞,致使包括“一码通”在内的部分应用系统无法正常使用。“

一码通”后台监控第一时间报警,各24小时驻场通信、网络、政务云、安全和运维团队立即开展排查,平台应用系统和数据库运行正常,判断问题出现在网络接口侧。

根据上面的信息,数据库和平台系统都正常,是网络出现了问题。

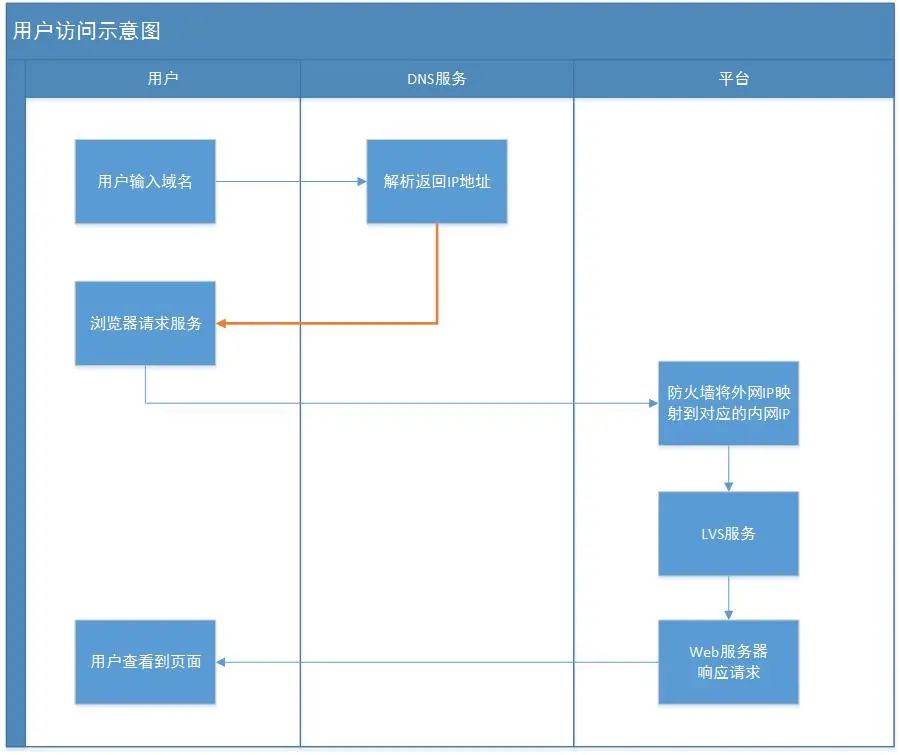

我之前在文章《一次dns缓存引发的惨案》画过一张访问示意图,用这个图来和大家分析一下,网络出现问题的情况。

一般用户的请求,会先从域名开始,经过DNS服务器解析后拿到外网IP地址,经过外网IP访问防火墙和负载之后打到服务器,最后服务器响应后将结果返回到浏览器。

如果真的是网络出现问题,一般最常见的问题就是 DNS 解析错误,或者外网的宽带被打满了。

DNS解析错误一定不是本次的问题,不然可能不只是这一个功能出错了;外网的宽带被打满,直接增加带宽就行,不至于一天都没搞定。

如果真的是网络侧出现问题,一般也不需要改动业务,但实际上系统恢复的时候,大家都发现界面回到文章开头提到了第一个版本了。

也就是说系统“回滚”了。

界面少了接种信息和核酸检测信息的内容,并且在一码通的首页位置,新增加了一个核酸查询的页面。

4

个人分析

根据我以往的经验,这是一个很典型的系统过载现象,也就是说短期内请求量超过服务器响应。

说人话就是,外部请求量超过了系统的最大处理能力。

当然了,系统最大处理能力和系统架构息息相关,同样的服务器不同的架构,系统负载量差异极大。

应对这样的问题,解决起来无非有两个方案,一个是限流,另外一个就是扩容了。

限流就是把用户挡在外面,先处理能处理的请求;扩容就是加服务器、增加数据库承载能力。

上面提到官方让大家没事别刷一码通,也算是人工限流的一种方式;不过在技术体系上基本上不会这样做。

技术上的限流方案有很多,但最简单的就是前面挂一个 Nginx 配置一下就能用;复杂一点就是接入层自己写算法。

当然了限流不能真正的解决问题,只是负责把一部分请求挡在外面;真正解决问题还是需要扩容,满足所有用户。

但实际上,根据解决问题的处理和产品回滚的情况来看,一码通并没有第一时间做扩容,而是选择了回滚。

这说明,在系统架构设计上,没有充分考虑扩容的情况,所以并不能支持第一时间选择这个方案。

5

理想的方案?

上面说那么多也仅仅是个人推测,实际上可能他们会面临更多现实问题,比如工期紧张、老板控制预算等等…

话说回来,如果你是负责一码通公司的架构师,你会怎么设计整个技术方案呢?欢迎大家留言,这里说说我的想法。

第一步,读写分离、缓存。

至少把系统分为2大块,满足日常使用的读业务单独抽取出来,用于承接外部的最大流量。

单独抽出一个子系统负责业务的更新,比如接种信息的更新、核酸信息的变化、或者根据业务定时变更码的颜色。

同时针对用户大量的单查询,上缓存系统,优先读取缓存系统的信息,防止压垮后面的数据库。

第二步,分库分表、服务拆分。

其实用户和用户之间的单个查询是没有关系的,完全可以根据用户的属性做分库分表。

比如就用用户ID取模分64个表,甚至可以分成64个子系统来查询,在接口最前端将流量分发掉,减轻单个表或者服务压力。

上面分析没有及时扩容,可能就是没有做服务拆分,如果都是单个的业务子服务的话,遇到过载的问题很容易做扩容。

当然,如果条件合适的话,上微服务架构就更好了,有一套解决方案来处理类似的问题。

第三步,大数据系统、容灾。

如果在一个页面中展示很多信息,还有一个技术方案,就是通过异步的数据清洗,整合到 nosql 的一张大表中。

用户扫描查询等相关业务,直接走 nosql 数据库即可。

这样处理的好处是,哪怕更新业务完全挂了,也不会影响用户扫码查询,因为两套系统、数据库都是完全分开的。

使用异地双机房等形式部署服务,同时做好整体的容灾、备灾方案,避免出现极端情况,比如机房光缆挖断等。

还有很多细节上的优化,这里就不一一说明了,这里也只是我的一些想法,欢迎大家留言补充。

6

最后

不管怎么分析,这肯定是人祸而不是天灾。

系统在没有经过严格测试之下,就直接投入到生产,在强度稍微大一点的环境中就崩溃了。

比西安大的城市很多,比西安现在疫情还要严重的情况,其它城市也遇到过,怎么没有出现类似的问题?

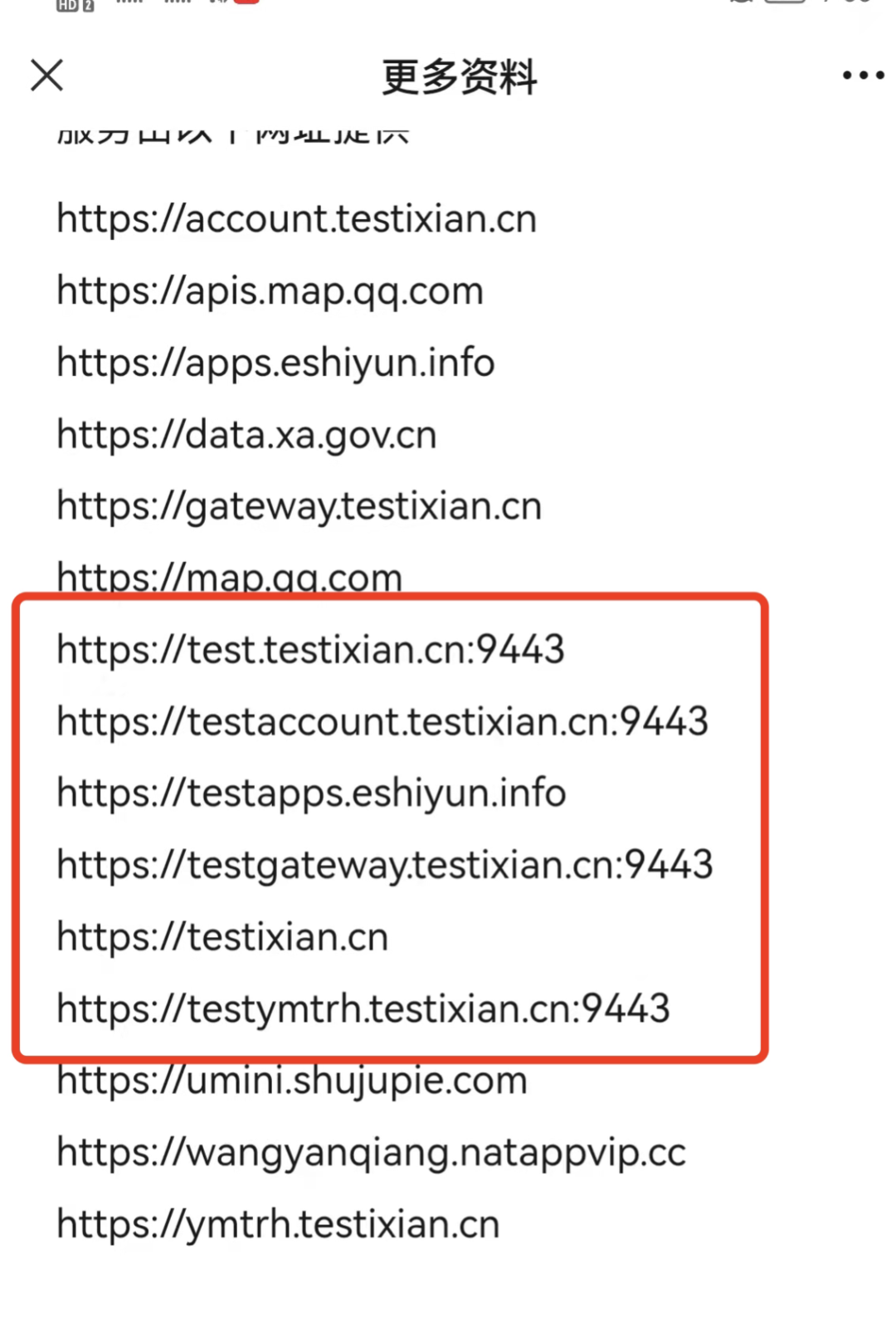

西安做为一个科技大城,出现这样的问题真的不应该,特别是我看了这个小程序背后使用的域名地址之后。

有一种无力吐槽的感觉,虽然说这和程序使用没有关系,但是从细节真的可以看出一个技术团队的实力。

虽然大家都不容易,但还是希望这次能够吸取教训,避免再次出现类似的问题!

西安,长安,加油!

希望疫情尽快结束!大家早日恢复到正常的生活来。

0 条评论