浏览次数: 288

近日,流传了一份OpenAI工程师的作息时间,其中有一项就是背诵强化学习之父、加拿大计算机科学家理查德·萨顿( Richard S. Sutton )的经典文章《The Bitter Lesson(苦涩的教训)》。该文章指出过去 70 年来,AI 研究走过的最大弯路,就是过于重视人类既有经验和知识,而他认为最大的解决之道是摒弃人类在特定领域的知识、利用大规模算力的方法,从而获得最终胜利。

这一观点被OpenAI首席科学家Ilya Sutskever认同,并总结为算力常胜。

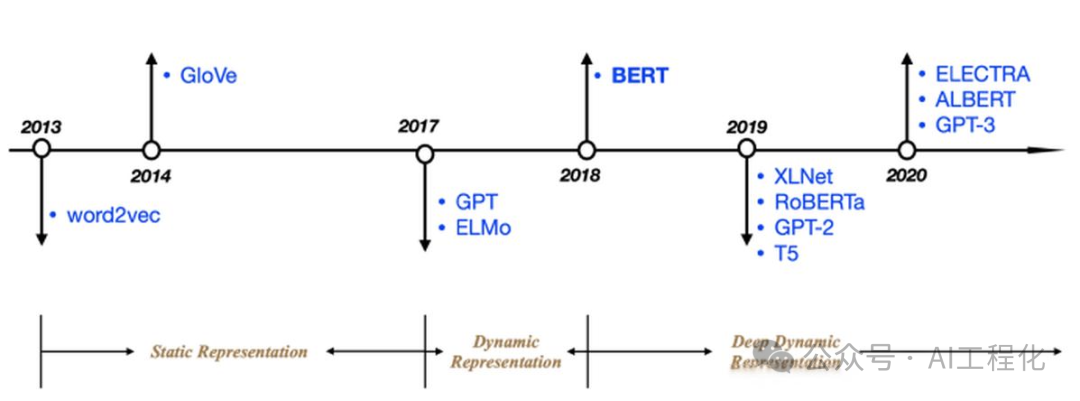

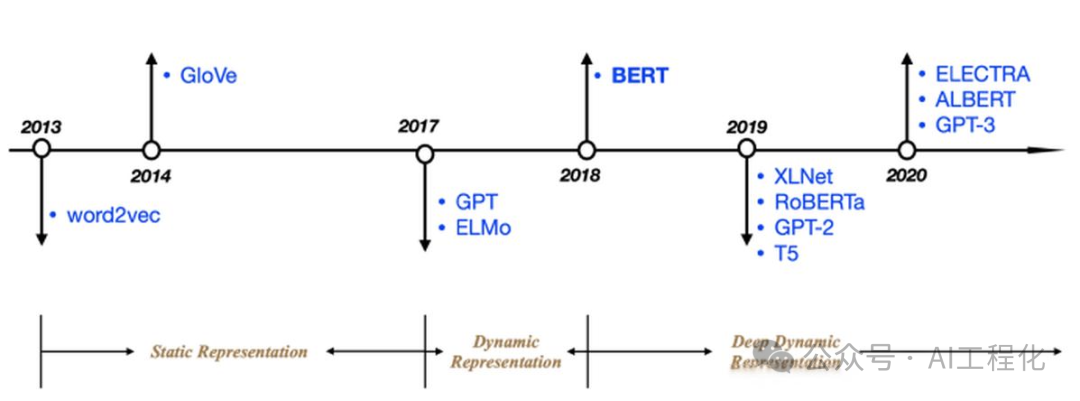

从这个角度结合Gpt模型发布时间线看,萨顿的思想给了很大的精神支持,从而使得堆算力的路线得以持续坚持,为后来明确提出大模型的Scaling Law奠定了基础。Scaling Law[1]和LLM is compressors的关键认知成为OpenAI破局的关键指导,就拿最近的sora来讲,也是scaling law的胜利。

70年来人工智能研究给我们的最深刻教训是:那些能够发挥计算力的通用方法终将大获成功。其背后的根本原因是摩尔定律(Moore’s law),也就是计算单位成本持续指数型下降这一现象的普遍规律。绝大多数AI研究都是在这样一种假设下进行的:智能体可使用的计算资源是不变的(在这种情况下,发挥人类知识将是提升性能的主要手段)。然而,随着时间的推移,超出一般科研项目周期后,庞大的计算资源终将成为现实。虽然研究人员希望在短期内依靠人类的领域知识取得突破,但长远来看,真正重要的是计算能力的发挥。这两种方法不必是对立的,但实践中它们往往相悖。在一个上的投入就意味着牺牲另一个。人们对某种方法的投入往往有着心理上的坚持。基于人类知识的方法通常会使程序复杂化,因而不能很好地利用那些发挥计算力的通用方法。有许多AI研究者在项目后期才痛苦地吸取到这一课,在这里回顾几个最突出的例子,我们将能获得宝贵的启示。在计算机国际象棋领域,1997年战胜世界冠军卡斯帕罗夫的方法依靠的是深度而广泛的搜索策略。当时,大部分致力于发挥人类对象棋独特结构理解的研究者对此感到失望。当一种更简单的、基于搜索的方法,结合专门的硬件与软件得到证实极为有效时,这些基于人类知识的象棋研究者们没有好好接受失败。他们声称这次“暴力”搜索可能赢了,但并非普遍有效的策略,并且这并不是人类下棋的方式。这些研究人员期待基于人类直觉的方法能取胜,结果却感到失望。计算机围棋的研究进展出现了相似的模式,只不过落后于计算机国际象棋研究20年。最初,研究者投入巨大努力来避免通过搜索解决问题,而是试图利用人类对围棋特殊性质的认识,但所有这些努力一旦在大规模搜索得到有效应用后,就显得无关紧要,甚至是错误的。自我对弈的学习策略对学习价值函数也极为关键(这在很多其他游戏中和国际象棋中也很重要,尽管在1997年第一次击败世界冠军的程序中学习的角色不大)。无论是自我对弈的学习还是一般意义上的学习都类似于搜索,能够利用巨量的计算资源。在人工智能研究中,搜索和学习是利用海量计算资源的两种最关键的技术类别。无论在计算机围棋还是计算机国际象棋,研究的初衷都是减少搜索需求,希望通过人类的认知来达到目的,然而,只有在很多年之后,通过接受搜索和学习,才获得了巨大的成功。在语音识别领域,20世纪70年代有一场由DARPA赞助的早期竞赛。参与者呈现了多种特殊方法,这些方法利用了对词汇、音素、人声道等方面的人类知识。而对立面则是采用了更多基于统计的方法,这些方法执行了更多的计算,基础是隐马尔可夫模型 (HMMs)。统计方法再次胜出。这引发了自然语言处理领域的重大转变,数十年来统计和计算力逐渐占据了主导地位。深度学习在语音识别中的崛起是沿这一方向迈出的最新步伐。

70年来人工智能研究给我们的最深刻教训是:那些能够发挥计算力的通用方法终将大获成功。其背后的根本原因是摩尔定律(Moore’s law),也就是计算单位成本持续指数型下降这一现象的普遍规律。绝大多数AI研究都是在这样一种假设下进行的:智能体可使用的计算资源是不变的(在这种情况下,发挥人类知识将是提升性能的主要手段)。然而,随着时间的推移,超出一般科研项目周期后,庞大的计算资源终将成为现实。虽然研究人员希望在短期内依靠人类的领域知识取得突破,但长远来看,真正重要的是计算能力的发挥。这两种方法不必是对立的,但实践中它们往往相悖。在一个上的投入就意味着牺牲另一个。人们对某种方法的投入往往有着心理上的坚持。基于人类知识的方法通常会使程序复杂化,因而不能很好地利用那些发挥计算力的通用方法。有许多AI研究者在项目后期才痛苦地吸取到这一课,在这里回顾几个最突出的例子,我们将能获得宝贵的启示。在计算机国际象棋领域,1997年战胜世界冠军卡斯帕罗夫的方法依靠的是深度而广泛的搜索策略。当时,大部分致力于发挥人类对象棋独特结构理解的研究者对此感到失望。当一种更简单的、基于搜索的方法,结合专门的硬件与软件得到证实极为有效时,这些基于人类知识的象棋研究者们没有好好接受失败。他们声称这次“暴力”搜索可能赢了,但并非普遍有效的策略,并且这并不是人类下棋的方式。这些研究人员期待基于人类直觉的方法能取胜,结果却感到失望。计算机围棋的研究进展出现了相似的模式,只不过落后于计算机国际象棋研究20年。最初,研究者投入巨大努力来避免通过搜索解决问题,而是试图利用人类对围棋特殊性质的认识,但所有这些努力一旦在大规模搜索得到有效应用后,就显得无关紧要,甚至是错误的。自我对弈的学习策略对学习价值函数也极为关键(这在很多其他游戏中和国际象棋中也很重要,尽管在1997年第一次击败世界冠军的程序中学习的角色不大)。无论是自我对弈的学习还是一般意义上的学习都类似于搜索,能够利用巨量的计算资源。在人工智能研究中,搜索和学习是利用海量计算资源的两种最关键的技术类别。无论在计算机围棋还是计算机国际象棋,研究的初衷都是减少搜索需求,希望通过人类的认知来达到目的,然而,只有在很多年之后,通过接受搜索和学习,才获得了巨大的成功。在语音识别领域,20世纪70年代有一场由DARPA赞助的早期竞赛。参与者呈现了多种特殊方法,这些方法利用了对词汇、音素、人声道等方面的人类知识。而对立面则是采用了更多基于统计的方法,这些方法执行了更多的计算,基础是隐马尔可夫模型 (HMMs)。统计方法再次胜出。这引发了自然语言处理领域的重大转变,数十年来统计和计算力逐渐占据了主导地位。深度学习在语音识别中的崛起是沿这一方向迈出的最新步伐。

深度学习方法更少依赖人类知识,利用了大量的计算资源,并且通过在巨量训练数据集上进行学习,大幅提升了语音识别系统的性能。就像在游戏领域一样,研究人员总是试图打造出与他们心中想象的思维方式相匹配的系统——他们尝试将这种认知融入系统中——但这最终证明是适得其反的,因为当摩尔定律(Moore’s law )使得大量计算成为可能,并找到了有效利用这些计算资源的方法时,它反而成为了研究者时间的巨大浪费。

在计算机视觉领域,也出现了类似的模式。早期方法将视觉处理想象为寻找边界、泛化的圆柱体或者基于SIFT特征的过程。但现在这些做法都被淘汰了。现代深度学习神经网络采用卷积以及特定种类的不变性这些概念,取得了更好的成绩。

这是一个重要的教训。作为一个领域,我们还未完全领悟这些,因为我们还在重复同样的错误。为了理解这些错误的吸引力,并有效地克服它们,我们需要学习的是:长远来看,试图构建和我们自以为的思维方式相符的系统是行不通的。这个苦涩的教训来自这样一些历史观察:

1)AI研究者经常尝试将知识植入他们的智能体;

2)这在短期内似乎总是有益的,并能给研究者带来满意感;

3)但从长期看,这种方法迟早会遇到发展瓶颈,甚至阻碍进一步的进展;

4)真正的突破性进展最终是通过一个与此相反的方法实现的,这一方法依赖于通过搜索和学习来扩展计算能力。

最终的成功带着苦涩,并且往往难以被完全接受,因为它推翻了那些受到人们偏爱的以人为中心的方法。

从这苦涩的教训中我们应该明白,通用的方法具有巨大的力量,即使是在可用的计算能力变得极其巨大的情况下,这些方法依然可以继续拓展和升级。能够如此无限扩展的两种方法是搜索和学习。

从这苦涩的教训中我们应该吸取的第二个要点是,心智的真实内容极其复杂和深邃;我们应当停止寻找简单化地理解心智内容的方法,比如简单的空间感、物体、多智能体交互或对称性等。这些都是外在世界任意复杂性的一部分,它们的复杂性是无穷的,因此我们不应该将它们内置于系统中;相反,我们应该只构建那些能够发现并捕捉这些任意复杂性的元方法。这些方法的核心在于它们能找到良好的近似,但是发现它们的过程应该依赖我们的方法,而不是我们个人。我们希望创建的AI智能体能像我们一样进行发现,而不是仅仅包含我们所发现的内容。将我们的发现内置于系统中,只会使得理解发现过程本身变得更加困难。

原文:http://www.incompleteideas.net/IncIdeas/BitterLesson.html

LLM is compressors:

Scaling Laws for Neural Language Models:https://arxiv.org/abs/2001.08361

0 条评论